MADRID, 18 de abril. (Portal/EP) – Un actor malicioso intentó engañar a un empleado de LastPass utilizando una técnica “deepfake”, enviándole al menos un mensaje de voz a través de la plataforma de comunicación WhatsApp en el que se hacía pasar por el CEO de la empresa. Las voces “deep fake” se crean utilizando herramientas de inteligencia artificial (IA) para crear copias sintéticas de las voces de otras personas.

Esto es posible porque la tecnología utiliza técnicas de aprendizaje profundo para reproducir la voz con un sonido realista y convincente, debido a su parecido con la voz humana. LastPass informa que recientemente uno de los empleados de la empresa, posible víctima de una estafa de este tipo, pudo reconocer el engaño, después de que el director general de la empresa, Karim Toubba, se pusiera en contacto de emergencia con él. La compañía dijo que este tipo de estafa deepfake no tuvo ningún impacto en la empresa y se llevó a cabo fuera de los canales de comunicación normales de la empresa.

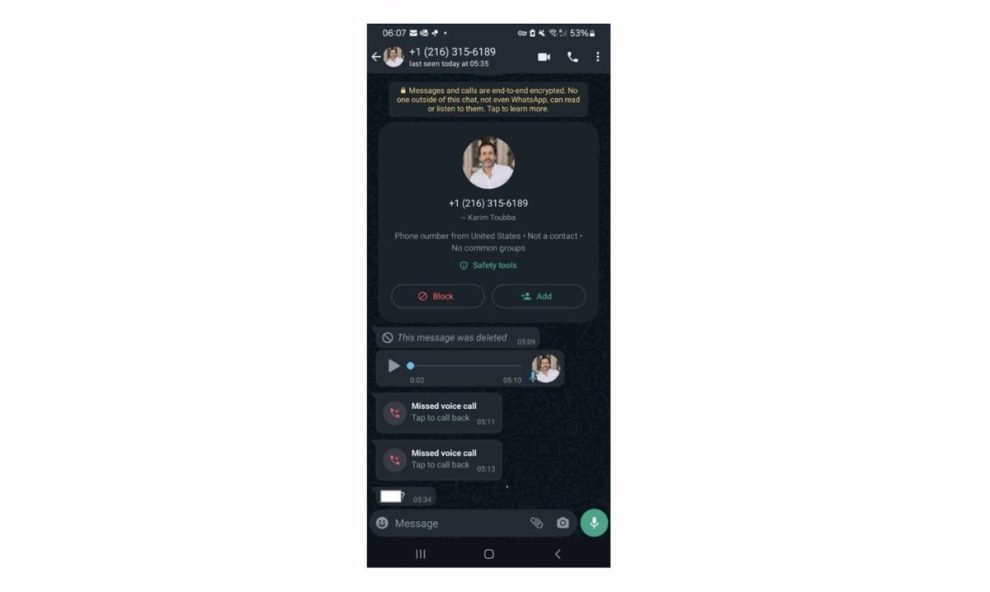

En este caso fue a través de WhatsApp, app donde hacían una serie de llamadas, enviaban mensajes de texto y al menos una nota de voz de la persona. Esto hizo que el empleado sospechara del accionar del supuesto ejecutivo de la empresa, por lo que ignoró los mensajes destinados a llamar su atención y reportó el incidente al respectivo servicio LastPass. La compañía reiteró que los “deepfakes” son cada vez más comunes, y no solo en el ámbito de los sofisticados actores de amenazas estatales, sino que se han vuelto más comunes en los últimos meses.

Por este motivo, han trabajado con socios de inteligencia y otras empresas de ciberseguridad para crear conciencia sobre este formato y ayudar a las organizaciones a ir un paso por delante de los estafadores. FÁCIL DE CREAR La clonación de voz utiliza la voz real de otro individuo para crear una representación realista del original, por lo que para crear un ‘deepfake’ sólo se necesita recolectar una o más muestras de voz del habla humana que se quiera reproducir, ya sea a través de audio de video o mediante un dispositivo físico. Grabación de una persona hablando.

Una vez recogida la muestra, se analiza mediante un software para determinar las características del habla y se utiliza para entrenar un modelo de aprendizaje automático, con un algoritmo capaz de imitar la voz original. Además de que los ‘deepfakes’ son relativamente fáciles de crear, cada vez son de mayor calidad y ahora hay muchos sitios web y aplicaciones disponibles para hacerlo, razón por la cual esta técnica se ha vuelto tan popular entre los ciberdelincuentes, tanto entre el público. nivel -en redes sociales y foros-, así como a nivel privado, es decir, en las empresas.

En 2019, una empresa del Reino Unido descubrió un audio ‘deepfake’ y acordó permitir que un empleado transfiriera dinero a un comerciante que utilizaba un ‘software’ de generación de inteligencia artificial para dirigir la empresa. Más recientemente, en febrero de este año, un empleado de una multinacional británica con sede en Hong Kong fue víctima de un vídeo y una voz ‘deepfake’ en el que unos estafadores de la isla robaban casi 200 millones de dólares de Hong Kong (unos 24 millones de euros). .

Esto fue posible porque los ciberdelincuentes utilizaron imágenes de directores financieros y otros ejecutivos de sucursales para contactar a las víctimas y pedirles que realizaran transferencias de dinero.