La inteligencia artificial (IA) está haciendo cada vez más reales las llamadas deep fakes (vídeos, imágenes y sonidos generados imitando la apariencia y la voz de una persona).

Una mañana de octubre, Elise, una adolescente de 14 años de Texas, se despertó y encontró varias imágenes suyas desnuda adjuntas a llamadas perdidas y mensajes de texto que circulaban por las redes sociales.

Las fotos falsas -desnudos superpuestos a su rostro real- se enviaron a compañeros de clase, y el engaño era inimaginable.

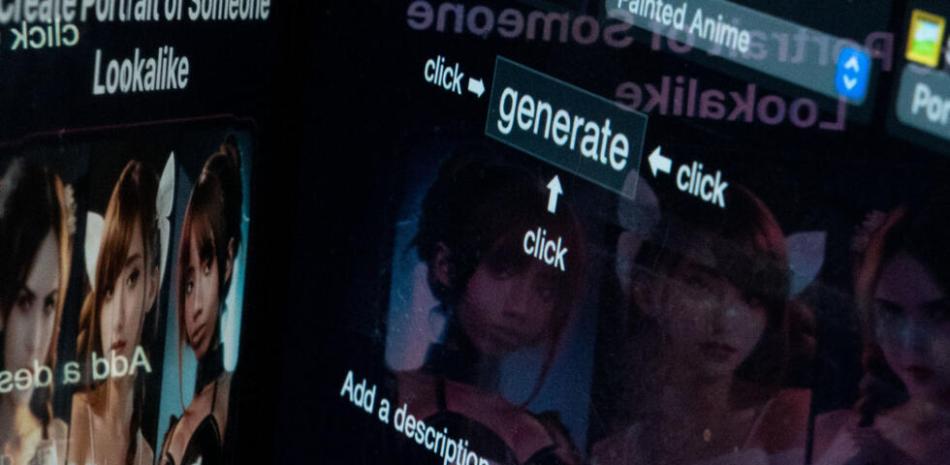

La inteligencia artificial (IA) está haciendo cada vez más reales los llamados deep fakes (vídeos, imágenes y sonidos generados imitando la apariencia y la voz de una persona).

Las imágenes originales de Elise y su amiga, que también fue víctima, fueron tomadas de Instagram, según explicó a AFP la estudiante de secundaria.

Así como las de las niñas y otras compañeras de clase. Las fotos se compartieron después en la aplicación móvil Snapchat.

Los cuerpos [desnudos] parecían cadáveres reales, dijeron las adolescentes. Y recuerdo estar muy, muy asustada.

A medida que se ha desarrollado la IA, también lo ha hecho la pornografía deep-fake que utiliza imágenes y vídeos ultrarrealistas que pueden crearse con un mínimo esfuerzo y financiación, lo que ha provocado escándalos y acoso en varios institutos estadounidenses.

Las autoridades intentan compensar la falta de una ley federal que prohíba esta práctica.

Las chicas lloraban todo el tiempo. Anna McAdams, la madre de Elise, estaba conmocionada por lo reales que eran las imágenes. Las niñas no querían ir al colegio.

– Un teléfono móvil y unos pocos dólares.

No está claro lo extendida que está esta práctica, pero está muy extendida.

A finales de este mes, se produjo otra estafa de desnudos falsos en un centro del noreste de Nueva Jersey.

Una de las víctimas, la madre Dorota Mani, también de 14 años, dijo que esto ocurriría cada vez más a menudo.

Añadió que falsificaciones profundas de pornografía podrían estar circulando por Internet sin su conocimiento y que sólo se investigarían si la víctima hablaba.

Se quejó de que muchas víctimas ni siquiera saben que las imágenes están ahí y no pueden protegerse porque no saben lo que pasa.

Los expertos afirman que, aunque la pornografía falsa de famosos existe desde hace años, la ley tardó en ponerse al día con esta tecnología.

Ahora, sin embargo, cualquiera con una foto en LinkedIn puede ser víctima.

Henry Farid, profesor de informática de la Universidad de California en Berkeley, declaró a la AFP.

El mes pasado, el Presidente de Estados Unidos, Joe Biden, firmó un decreto presidencial sobre la IA en el que pedía al gobierno que creara barreras a la producción de material de abusos sexuales a menores y de imágenes íntimas no consentidas de personas reales.

En muchos casos, es difícil localizar a los creadores de las imágenes, pero Farid cree que esto no debe impedir que se exijan responsabilidades a las empresas de IA que están detrás de ellas o a las plataformas de redes sociales en las que se comparten las imágenes.

El problema es que no existe ninguna ley nacional que regule esta pornografía y sólo unos pocos estados han aprobado leyes que la regulan.

Renee Cummings, especialista en ética de la IA, afirma que aunque tu cara se superponga a un cuerpo, ese cuerpo no es realmente el tuyo.

La profesora Cummings, de la Universidad de Virginia, dijo a AFP que esto podría crear un conflicto en la ley porque podría argumentarse que las leyes existentes que prohíben la distribución de fotografías sexuales de alguien sin su consentimiento no se aplican a los deepfakes. Y cualquiera con un smartphone y unos pocos dólares puede capturar imágenes, y muchas víctimas, principalmente mujeres y adolescentes, temen hacerlas públicas.

La pornografía deepfake puede destruir la vida de alguien, reconoció Cummings, citando víctimas que sufren ansiedad, depresión y trastorno de estrés postraumático.

Sin embargo, la situación parece haber cogido desprevenidos a los sistemas educativo y judicial.

Estoy desolada porque no hay ningún elemento que pueda decir: ‘Sí, esto es pornografía infantil'”, declaró la madre, McAdams.

El compañero que creó las fotos de Elise fue expulsado temporalmente del colegio, pero la víctima ya no es sociable ni extrovertida. Vive con ansiedad y quiere cambiar de colegio.

No sé cuántas personas podrían haber guardado y enviado las fotos. No sé cuántas fotos se hizo, dice. Mucha gente podría haber recibido las fotos.

A su madre le preocupa que las fotos vuelvan a aparecer en Internet.